Сексизм и расизм. Почему ИИ нельзя показывать фото Трампа по поисковому слову idiot

"Искусственный интеллект (ИИ) может оказаться сексистом и расистом", - предупреждает журнал Nature. К такому мнению пришли Джеймс Цзоу и Лонда Шибенгер из Стэнфордского университета. Ученые изучили огромный массив искажений, которые допускаются ИИ, советуют коллегам-компьютерщикам изучить источники предвзятости и подумать над тем, как ее избежать.

Например, когда Google Translate переводит новости с испанского на английский, прямая речь, исходящая от женщин, подается в форме "он сказал" - в испанском, в отличие от английского, местоимения могут не употребляться с глаголом, и по умолчанию переводчик ставит "он".

Еще один пример, приведенный исследователями, - из области распознавания изображения. Когда изображение немного нечеткое, представители азиатской расы почти обречены оказаться на фото с закрытыми глазами.

Это довольно безобидные примеры. Могут быть ситуации похуже. Например, когда ИИ помогает полиции распознавать в уличной толпе потенциальных правонарушителей.

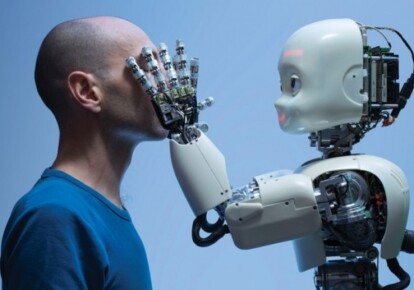

Учитывая то, что ИИ становится все более популярным инструментом принятия решений, касающихся людей, - от моделирования поведения на улице до выбора будущего сотрудника из множества кандидатов на вакансию, - пристрастность этого инструмента может оказаться серьезным вызовом. Согласитесь, довольно неожиданным. Мы-то, напротив, надеялись, что ИИ окажется идеальным инструментом, лишенным наших человеческих слабостей. Рациональным и безошибочным. И за это, кстати, многие заведомо его невзлюбили.

Но, оказывается, (почти) ничто человеческое ИИ не чуждо. И этому не приходится удивляться, учитывая то, как собираются, обрабатываются и организуются данные для обучения ИИ.

Именно тут, считают Цзоу и Шибенгер, зарыта собака. Снова ничего удивительного - не так ли? На чем нас учат - в то мы и верим. Так вот, обучение нейронных сетей происходит на массивах картинок, снабженных подписями, и текстов, собранных в интернете. Популярностью пользуются картинки Google и новости Google, где изображения и слова соотносятся с условиями запроса, или на материале Wikipedia. Эти массивы данных собираются, а потом аннотируются - часто студентами-старшекурсниками или с помощью краудсорсинговых платформ. Такая методика, убеждены исследователи, непреднамеренно приводит к тому, что ИИ скармливают данные, содержащие гендерные, этнические и культурные предубеждения.

Просто потому, что, например, какие-то группы хорошо представлены в интернете, а какие-то хуже. Так, более 45% данных ImageNet, которые используют для исследований в области компьютерного зрения, поступают из Соединенных Штатов, где проживает всего 4% населения мира. В то время как Китай и Индия вместе взятые составляют всего 3% данных ImageNet, притом что данные страны - это 36% мирового населения. Что в результате? Искусственный интеллект убежден, что если свадьба, то женщина одета в белое платье и фату. А если на картинке изображена индийская свадьба, то ИИ уверен, что имеет дело со спектаклем или этнофестивалем.

Это, разумеется, из области курьезов, хоть и говорит кое-что о степени предвзятости ИИ. Но бывают вещи и посерьезнее. В прошлом году исследователи использовали глубокое обучение для выявления рака кожи по фотографиям. Они обучили свою модель, используя набор данных из 129 450 изображений, из которых 60% были взяты из GoogleImages. Проблема в том, что менее 5% этих изображений принадлежали темнокожим людям, и алгоритм оказался неэффективным для них. Тут невольный "расизм" ИИ может иметь фатальные последствия.

"Если конкретная группа лиц появляется чаще, чем другие, в данных обучения, программа будет оптимизирована для этих людей, поскольку это повышает общую точность", - пишут Цзоу и Шибенгер. Обучение оказывается в прямой зависимости от того, "кого больше в интернете". В общем, можно, наверное, предположить, что изображение Дональда Трампа по поисковому слову idiot может отразиться на поведенческих реакциях некоторых видов ИИ.

"Чем больше, тем больше": чем чаще проявляется связь или зависимость, тем больше вероятность того, что ИИ выберет подобную зависимость по умолчанию. Если в английском языке соотношение мужских и женских местоимений составляет два к одному, то Google Translate по умолчанию выберет при переводе именно "он", если местоимение не указано, так как это случается при переводе с испанского. Но все даже хуже, потому что таким образом в массиве текстов для обучения перекос еще больше нарастает, увеличивая частоту употребления именно мужского местоимения. Что, по мнению ученых, ставит под угрозу социальные достижения - ведь еще в 60-х годах прошлого века это соотношение составляло четыре к одному. И вот искусственный интеллект безотчетно двигает нас назад, к исходной точке.

Проблема "пристрастности" ИИ отражает до сих пор существующий дисбаланс, который все больше остается в истории, но может оказать неожиданный эффект на будущее. Так, например, в "Википедии" - популярном источнике образовательных материалов для ИИ - менее 18% биографических записей относятся к женщинам. Статьи о женщинах чаще ссылаются на статьи о мужчинах, чем наоборот. В результате для поисковых систем мужчины - популярнее, чем женщины. А значит, и более значимые.

Исследователи убеждены, что такой стеоритипизации ИИ можно избежать, если принять во внимание дисбаланс, неизбежный при пользовании случайными наборами данных из интернета. Наборы для обучения должны быть сбалансированными по признаку пола и этнической принадлежности. В общем, не стоит "кормить" ИИ чем попало. Программы обучения нужно составлять тщательно - не только для людей, но и для машин. Иначе с машинами обязательно наступишь на те же грабли, что и с людьми.

Еще один интересный вывод из исследования стэнфордских ученых - о богатстве и бедности в информационную эпоху. "Доступ" - самое главное слово современности. Вы можете быть меньшинством, но если вы богаты - у вас неограниченный доступ и возможность широко раскинуться в информационном пространстве, - то становитесь в определенном смысле "большинством", на которое ориентируются и работают самые современные инструменты.

Вывод из этого простой: если вы недовольны качеством перевода Google Translate, то это не вина ИИ. Это проблема малого количества текстов на вашем языке в интернет-пространстве. Пишите больше. И не на английском, а на родном.

Отчасти в этом исследовании мы также получили ответ на тревожащий пытливые умы вопрос: будет искусственный интеллект похож на наш или нет? Так вот, не просто будет похож, он становится квинтэссенцией всей истории наших ценностей, представлений, предубеждений, страхов. Это ведь не отдельная ветвь эволюции - это наше творение. И оно несет в себе отпечаток своих творцов.

Искусственный интеллект, созданный в рамках каждой из культур, будет "представителем" своей культуры, и только в этом случае он может быть использован для некоторых видов заданий. Например, для тотальной слежки в Китае не подойдет ИИ, обученный на корпусе либеральных текстов, маркирующих как позитивное все то, что противно истинному конфуцианскому духу. Поэтому ИИ не станет планетарным разумом. Во всяком случае на первом - сугубо прикладном - этапе. И вряд ли он станет воевать против человека на следующих этапах. Скорее его целью станут братья по искусственному разуму, воспитанные на других ценностях и расходующие ценные энергоресурсы на то, что будет маркировано "вредным" или "ненужным". Люди же окажутся всего лишь случайными жертвами войн между ИИ, вобравшими в себя ценности, представления, идеи и предубеждения каждой из культур.